La IA ya no es un experimento paralelo: se ha convertido en infraestructura operacional. Los presupuestos son medibles, los paneles ejecutivos incluyen KPIs de IA y cada unidad de negocio quiere una parte de la promesa. Pero pasar del potencial a la producción viene con nuevas fricciones.

La tecnología en sí ya no es el principal desafío. El costo real aparece cuando los líderes deben hacer que la IA sea consistente: lo suficientemente confiable como para confiar, lo suficientemente gobernada para escalar y lo suficientemente eficiente como para justificar. Cada uno de estos requiere no solo arquitectura técnica, sino disciplina organizacional, y ahí es donde la mayoría de las estrategias fallan.

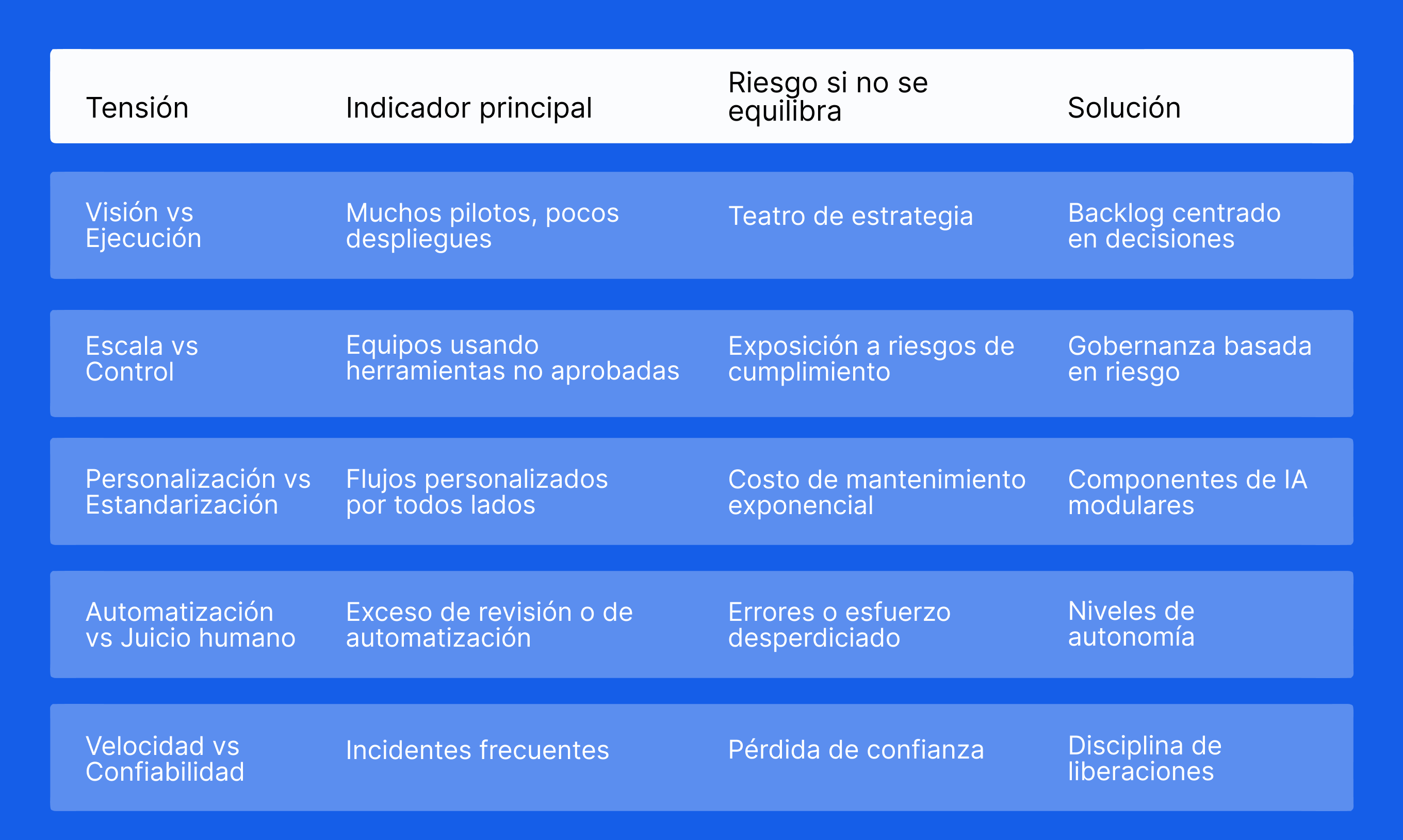

En todas las industrias, cinco tensiones recurrentes definen el estado de madurez de la IA en 2025. No son obstáculos, sino limitaciones de diseño: compensaciones predecibles que todas las organizaciones deben navegar.

Rereconocerlos temprano no facilita la IA, pero hace que el progreso sea repetible y las reversiones sean menos costosas.

1. Visión vs. ejecución: La brecha cada vez mayor entre los mazos de estrategia y las implementaciones reales

Cada empresa tiene ahora una declaración de visión de IA: aumentar equipos, automatizar procesos, personalizar experiencias, reducir riesgos.

Sin embargo, pocos pueden mostrar sistemas de trabajo que ofrezcan esos resultados. La brecha entre las barajas de estrategia y los productos implementados se ha convertido en uno de los problemas definitorios de la adopción de IA.

Donde la mayoría de las estrategias fallan

- No hay un único propietario de decisión. Los equipos de producto definen las características, la TI posee infraestructura, el riesgo define los controles, pero nadie es dueño de la decisión end-to-end que se supone que la IA debe mejorar.

- Parálisis piloto. Decenas de pruebas de concepto siguen estancadas porque los criterios de éxito nunca se definieron en términos operativos medibles.

- Wish-casting de datos. Las estrategias dependen de un conjunto de datos futuro idealizado (limpio, etiquetado, unificado) en lugar de los datos desordenados y parciales que realmente existen hoy en día.

Cómo se ve la ejecución disciplinada

- Definir la decisión, no el modelo. “Aprobar o rechazar a un proveedor en menos de dos horas con menos de 1% de error” es una decisión. “Implementar detección de anomalías” es una característica. Uno impulsa el valor del negocio; el otro impulsa la actividad.

- Escriba las pruebas de aceptación antes del modelo. Establezca techos de latencia, umbrales de precisión por segmento, reglas de escalamiento y activadores de retroceso. Trate estos como especificaciones funcionales, no después de pensamientos.

- Adopte una cadencia de liberación de IA. Embacar en incrementos pequeños y medibles. Por ejemplo, reduzca el tiempo de manejo de soporte en un 15% en un solo flujo de trabajo antes de ampliar el alcance. Las pequeñas victorias se combinan más rápido que los pilotos ambiciosos que nunca se envían.

Señales de que la visión y la ejecución están finalmente alineadas

- Mantiene un backlog vivo de decisiones, cada una con un propietario claro, una fuente de datos y una métrica de performance.

- Las tarjetas modelo y los runbooks existen antes de que se haga la primera convocatoria de producción, no después de que algo se rompa.

- Puede deshabilitar un modelo sin interrumpir el proceso del negocio, lo que significa que la automatización es estructurada, no frágil.

2. Escala frente a control: cuando la innovación supera a la gobernanza

A medida que la IA se propaga a través de los departamentos, lo que comienza como innovación a menudo se convierte en fragmentación. Los equipos experimentan con modelos, integran API y automatizan los flujos de trabajo más rápido de lo que el gobierno interno puede adaptar. Lo que antes era un solo piloto se convierte rápidamente en un ecosistema distribuido de modelos, indicaciones y scripts que operan fuera de cualquier control unificado.

Para el liderazgo, el reto no es el entusiasmo. Es un descuido. ¿Cómo puede una organización fomentar la experimentación sin perder la pista de lo que se está implementando, de dónde provienen los datos o qué reglas se están aplicando?

Los riesgos de una escala incontrolada

- Inteligencia artificial en la sombra. Los equipos adoptan herramientas no aprobadas o insertan API externas en los flujos de trabajo principales. La visibilidad disminuye y, con ella, la capacidad de administrar el cumplimiento de normas o el riesgo de datos.

- Esfuerzos duplicados. Múltiples departamentos resuelven el mismo problema de manera diferente, utilizando marcos incompatibles que crean deuda técnica.

- Rezago de gobernanza. Las políticas se escriben después de la implementación en lugar de incorporarse en el proceso de desarrollo, lo que lleva a un ciclo de parches y corrección.

Cómo se ve el control efectivo

El control no se trata de limitar la innovación. Se trata de crear un marco que permita una velocidad responsable. El buen gobierno se siente invisible: guía la acción sin bloquearla.

- Principios centrales, ejecución local. Establezca un pequeño conjunto de reglas no negociables para la privacidad de datos, la validación de modelos y el uso del proveedor. Luego permita que los equipos construyan libremente dentro de esos límites.

- Supervisión basada en riesgos. No todos los sistemas de IA necesitan el mismo nivel de escrutinio. Clasifique los proyectos por riesgo: orientado al cliente versus interno, de asesoramiento versus autónomo, sensible versus de bajo impacto. Aplicar el nivel apropiado de pruebas y revisión a cada uno.

- La auditabilidad como característica predeterminada. Todas las predicciones, prontos y acciones deben ser rastreables. Los registros deben capturar datos de entrada, versión del modelo, resultado y cualquier intervención humana. Esto convierte el cumplimiento de normas de un pensamiento posterior a un hábito operativo.

Cómo operacionalizar el control

- Planos reutilizables. Proporcione arquitecturas de referencia para necesidades comunes, como el resumen de documentos o la puntuación predictiva, para que los equipos no las reinventan de manera insegura.

- Política integrada en código. Aplique restricciones automáticamente durante la compilación y la implementación, por ejemplo, bloqueando llamadas API externas que infrinjan las reglas de residencia de datos.

- Bucles de revisión continua. Trate los incidentes de IA de la misma manera que los ingenieros de confiabilidad del sitio manejan las interrupciones. Mantenga revisiones posteriores al incidente, corrija la causa raíz en el código o la política y haga que las lecciones estén disponibles en todos los equipos.

Señales de que la escala y el control están en equilibrio

- Cada activo de IA se puede rastrear desde el origen de datos hasta la salida, con una propiedad clara.

- Los constructores pueden innovar sin esperar aprobaciones manuales porque las reglas están integradas en sus herramientas.

- Las reuniones de gobierno se centran en las excepciones y los conocimientos, no en la policía del trabajo rutinario.

Cuando la innovación y el gobierno evolucionan juntos, la IA deja de ser un riesgo de cumplimiento de normas y comienza a funcionar como una infraestructura confiable.

3. Personalización vs. Estandarización: El costo de personalizar la IA a cada caso de uso

Todos los departamentos quieren que la IA se ajuste a “cómo funcionan”. Pero escalar cientos de flujos de trabajo personalizados es insostenible. Cuanto más aumenta la personalización, más deuda técnica, deriva y dependencia acumula la organización.

Esta tensión ahora es visible en todos los entornos empresariales, especialmente en las empresas de LATAM que modernizan las pilas heredadas mientras integran la IA de manera incremental.

Donde la tensión se vuelve destructiva

- Lógica fragmentada. Los equipos reescriben automatizaciones similares desde cero, produciendo reglas, agentes o conjuntos de datos incompatibles.

- Esparce del modelo. Existen varias versiones del “mismo” modelo, cada una adaptada a las peculiaridades de un equipo.

- Costo de mantenimiento oculto. La personalización acelera la adopción temprana pero multiplica el mantenimiento a largo plazo.

Cómo se ve un equilibrio sostenible

- Estandarización modular. Estandarizar el bloques de construcción, no el flujo de trabajo final. Deja que los equipos ensamblen flujos personalizados a partir de módulos aprobados.

- Plantillas de decisión. Cree plantillas reutilizables para decisiones comunes: aprobaciones, puntuación de riesgos, enrutamiento.

- Personalización local sólo en el borde. Permita que los equipos afinen los umbrales o las reglas del negocio mientras mantiene centralizados los flujos de datos, la lógica de validación y las barandillas.

Cómo Creai resuelve esta tensión en la práctica

El enfoque de Creai se basa en componentes reutilizables (OCR, resumen de documentos, automatización del flujo de trabajo, agentes virtuales, análisis de sentimiento) que se integran en cualquier proceso pero permanecen gobernados centralmente.

Esto preserva la velocidad sin sacrificar la consistencia, crítica para las organizaciones con operaciones distribuidas en México, Colombia, Chile o España.

Señales de que la escala y el control están en equilibrio

- Cada activo de IA se puede rastrear desde el origen de datos hasta la salida, con una propiedad clara.

- Los constructores pueden innovar sin esperar aprobaciones manuales porque las reglas están integradas en sus herramientas.

- Las reuniones de gobierno se centran en las excepciones y los conocimientos, no en la policía del trabajo rutinario.

Cuando la innovación y el gobierno evolucionan juntos, la IA deja de ser un riesgo de cumplimiento de normas y comienza a funcionar como una infraestructura confiable.

4. Automatización vs. juicio humano: donde termina la autonomía y comienza la supervisión

A medida que la IA se hace cargo de más tareas operativas, los líderes deben redefinir quién decide qué, bajo qué condiciones y con qué nivel de responsabilidad.

Esta tensión es especialmente visible en el servicio al cliente, el cumplimiento de normas y las operaciones de back-office.

La consecuencia de no definir fronteras

- Sobreautomatización. Los equipos automatizan decisiones que deben seguir siendo humanas, como rechazar a un proveedor o escalar un caso de fraude.

- Subautomatización. El miedo al riesgo obliga a los humanos a revisar cada sugerencia de IA, eliminando las ganancias de productividad para las que se creó la IA.

- Rendición de cuentas ambigua. Cuando un modelo comete un error, la propiedad se vuelve poco clara.

Cómo se ve la claridad

Niveles de autonomía definidos.

- Nivel 1: Automatización completa para tareas reversibles y de bajo riesgo.

- Nivel 2: Sugerencias de IA con aprobación humana obligatoria.

- Nivel 3: Humano en control para decisiones irreversibles o de alto riesgo.

Reglas de excepción críticas. Los sistemas deben escalar cuando la incertidumbre es alta o la calidad de los datos disminuye.

Diseño de colaboración humano-IA. Los diagramas de flujo de quién valida, cuándo y con qué evidencia crean una rendición de cuentas predecible.

Un ejemplo de LATAM

Una empresa de servicios financieros en México utilizó IA para clasificar documentos de riesgo pero requirió analistas humanos para validar anomalías. Resultado: procesamiento 35% más rápido sin comprometer el cumplimiento de normas, un enfoque que ahora se replica en varias operaciones de LATAM.

5. Velocidad frente a confiabilidad: La presión de implementar rápidamente sin romper la confianza

Los ejecutivos quieren que la IA sea entregada ayer. Pero la implementación apresurada introduce inestabilidad, problemas de calidad de datos, sesgo y errores inesperados en la producción.

Esta tensión es la más subestimada y la más cara.

¿Qué causa el colapso de la confiabilidad?

- Omitir requerimientos no funcionales. Techos de latencia, presupuestos de error, límites de recursos.

- Sin conjuntos de datos dorados. Los equipos se entrenan en conjuntos de datos inconsistentes y resultados esperables.

- Falta de monitoreo. La deriva pasa desapercibida hasta que los usuarios se quejan.

Cómo se ve la velocidad sostenible

- Disciplina de liberación de IA. Lanzamientos semanales o quincenales con criterios de aceptación predefinidos.

- Pruebas de estrés de preproducción. Pruebe en el peor de los casos, no en los casos ideales.

- Paneles de performance. Monitoreo en tiempo real de precisión, latencia, costos y deriva.

El entorno de velocidad de confiabilidad

Una lista de verificación simple que Creai utiliza antes de llevar cualquier sistema de IA a la producción:

- ¿Datos validados?

- ¿Casos perimetrales probados?

- ¿Se ha documentado la ruta de reversión?

- ¿Propietarios identificados?

- ¿Log y trazabilidad habilitados?

- ¿Plafón de costo establecido?

Un marco práctico: el mapa de tensión de liderazgo de IA

Una herramienta de diagnóstico rápido que los líderes pueden usar para identificar dónde está atascada su organización:

Conclusión: La madurez de la IA no es técnica, es arquitectónica

Las empresas que escalan la IA en 2025 no ganan debido a mejores modelos. Ellos ganan por mejor disciplina operativa:

- Mejores definiciones de decisión

- Mejores barandillas

- Mejor modularización

- Mejor propiedad

- Mejores prácticas de liberación

La IA se convierte en una infraestructura confiable cuando los líderes la tratan como tal. Para las empresas de LATAM y Europa, donde se cruzan los sistemas heredados, la presión regulatoria y los cuellos de botella de talento, las organizaciones que dominen estas tensiones establecerán el estándar competitivo durante años. Si está navegando por estas tensiones y desea un socio aplicado que priorce la ejecución, Creai ayuda a los equipos a diseñar, construir y operar sistemas de IA con rigor, velocidad e impacto medible.

Ya sea que necesite auditar su stack actual, optimizar un flujo de trabajo crítico o acelerar la adopción de IA de manera responsable, nuestro equipo puede darle soporte end-to-end. Ponte en contacto con Creai para explorar cómo podemos ayudarle a escalar la IA con claridad, consistencia y resultados operativos reales.

PREGUNTAS FRECUENTES

1. ¿Cuáles son los mayores desafíos de la adopción de IA empresarial en 2025?

Los principales desafíos son organizativos, no técnicos: alinear la visión con la ejecución, gobernar la IA a escala, equilibrar la personalización con la estandarización, definir límites de supervisión humana e implementar de manera confiable sin sacrificar la velocidad.

2. ¿Por qué los pilotos de IA no llegan a la producción?

Las causas comunes incluyen la falta de claridad en la toma de decisiones, la falta de criterios de aceptación, las dependencias de datos basadas en suposiciones poco realistas y la ausencia de una cadencia de publicación.

3. ¿Cómo pueden las empresas evitar la fragmentación de IA entre equipos?

Utilice una capa de gobierno centralizada con componentes de IA reutilizables, supervisión basada en riesgos y auditabilidad por defecto. Permitir autonomía solo dentro de barandillas aprobadas.

4. ¿Debería la IA automatizar las decisiones o solo apoyarlas?

Depende del riesgo. Las decisiones de bajo impacto pueden automatizarse por completo; las de alto impacto o irreversibles deben seguir siendo dirigidas por humanos con sugerencias de IA.

5. ¿Cómo pueden las empresas personalizar la IA sin crear deuda técnica?

Estandarice los módulos principales (validación, flujos de datos, indicaciones, control del modelo) y permita una personalización ligera en el borde del flujo de trabajo.

Historias similares

.png)